HISTORIA DE LA COMPUTACIÓN

En la historia de la ciencia, hay ciertos momentos claves en los que el ingenio e inteligencia de ciertas personas, aunados a toda una situación social e ideológica propicias, les permiten percibir algo que nadie antes había sido capaz de ver. En muchas ocasiones esta revolución en los conceptos viene acompañada de innovaciones tecnológicas que constituyen grandes saltos en el desarrollo de nuevos aparatos. De esta manera, nos encontramos con que en general el avance científico-tecnológico tiene dos tipos de etapas: en la primera surge una idea o descubrimiento innovador muy importante, y la segunda comprende los tiempos durante los cuales se maduran y establecen las ideas. Durante estos periodos, se construyen aparatos cada vez más elaborados con base en estos principios. Este proceso continúa hasta que surge una nueva idea que permite de nueva cuenta un avance significativo.

Con esta idea en mente, podríamos dividir la historia de la computación en varias etapas, cada una caracterizada por una revolución tecnológica importante. A continuación relataremos de manera muy general el desarrollo de la computación, desde sus orígenes hasta finales de los años ochenta.

Puede decirse que la historia de la computación comienza cuando el hombre adquiere la necesidad de contar. Seguramente en un principio el hombre comenzó a contar con los dedos, para después hacerlo mediante marcas en el piso o utilizando piedras. Con la invención de la escritura, diferentes civilizaciones encontraron sendas maneras de contar y más tarde, de efectuar operaciones. La figura 6 nos muestra, de una manera comparativa, algunos sistemas numerales.

Una de las escrituras más antiguas que se conoce es la egipcia. Esta civilización adoptó un sistema de contar de diez en diez, de manera que marcaban las unidades con líneas verticales y las decenas con un signo similar a la U invertida. Otras culturas adoptaron sistemas más complicados; por ejemplo, los babilonios contaban de 60 en 60, y aunque su sistema era muy poco práctico, se cree que de ellos provienen las bases del sistema actual de contar los minutos y los segundos.

Otra numeración antiguamente utilizada fue la romana, la cual era muy simple y permitía efectuar operaciones aritméticas aunque no con mucha sencillez. Aún perdura la tradición de utilizarla en algunos contextos específicos; por ejemplo, en las carátulas de los relojes, para denominar los tomos o capítulos de los libros, para escribir algunas fechas, etcétera.

Entre las culturas de América, es interesante señalar que los mayas contaron con un sistema numeral vigesimal muy avanzado y utilizaron el cero aun antes que en Europa o Asia.

Podríamos continuar esta lista señalando más culturas y explicando sus sistemas de numeración, sin embargo, tan sólo queremos hacer hincapié en lo siguiente: la forma en que contamos actualmente, eso es, utilizando el sistema decimal (arábico), no es ni la única posible ni la única correcta, sino sólo una forma que hemos heredado de nuestros antepasados y que ha sobrevivido por ser simple y adecuada para nosotros debido a que tenemos diez dedos en las manos.

El siguiente paso en el desarrollo de la computación se dio con la invención de aparatos útiles para efectuar operaciones matemáticas. El ábaco es la primera calculadora o computadora de que tenemos noticias. Aunque se inventó hace aproximadamente 4 000 años, aún tiene un uso muy amplio en algunos países de Asia, debido a que se trata de una calculadora muy rápida y práctica, útil para efectuar operaciones de adición, substracción, multiplicación y división.

El siguiente paso en el desarrollo de la computación se dio con la invención de aparatos útiles para efectuar operaciones matemáticas. El ábaco es la primera calculadora o computadora de que tenemos noticias. Aunque se inventó hace aproximadamente 4 000 años, aún tiene un uso muy amplio en algunos países de Asia, debido a que se trata de una calculadora muy rápida y práctica, útil para efectuar operaciones de adición, substracción, multiplicación y división.

Muchos años tuvieron que pasar antes de que se lograran progresos en el desarrollo de nuevas calculadoras. En 1617, el escocés John Napier inventa los llamados huesos de Napier o tablas de multiplicar (de donde proviene el nombre utilizado hasta nuestros días). Éstos consisten de una regla fija y otra móvil que se desliza sobre la primera, de manera que deja ver el producto de dos números cualesquiera (véase la figura 10). Posteriormente las tablas de Napier evolucionaron hasta llegar a la regla de cálculo, la cual funciona con el mismo principio pero es útil para llevar a cabo operaciones de multiplicación, división y raíz cuadrada, entre otras. Debido a su portabilidad, este artefacto tuvo una gran acogida en el mundo occidental y fue de uso frecuente hasta hace pocos años, cuando se generalizó el uso de las calculadoras de bolsillo.

A mediados del siglo

XVII se inicia una nueva era de calculadoras mecánicas cuando, en 1642, Blaise Pascal, quien sólo contaba con 19 años de edad, introduce una máquina sumadora mecánica con el objeto de facilitar los cálculos de su padre . Esta máquina consistía en un sistema con ruedas pequeñas acopladas entre sí y que, de derecha a izquierda correspondían a unidades, decenas, centenas, etcétera. Estas ruedas se encontraban divididas en 10 partes iguales; de manera que para efectuar una suma se hacían girar manualmente un número de pasos acorde con el número que se deseaba introducir. La rotación completa de un círculo en la dirección positiva, causaba automáticamente que el círculo a su izquierda avanzara una posición. Para efectuar sustracciones el proceso era el inverso

A mediados del siglo

XVII se inicia una nueva era de calculadoras mecánicas cuando, en 1642, Blaise Pascal, quien sólo contaba con 19 años de edad, introduce una máquina sumadora mecánica con el objeto de facilitar los cálculos de su padre

Maquina de Pascal

Algunos años más tarde, Leibniz inventa una máquina similar a la de Pascal pero más compleja, la cual podía sumar, restar, multiplicar y dividir.

Maquina de calcular de Leibnz

Babbage comienza un nuevo diseño, y así concibe una calculadora totalmente nueva: su "máquina analítica", la cual habría de ser más fácil de construir y tendría mayor poder de cálculo que la anterior. Así, diseña una computadora mecánica digital a la cual habrían de suministrársele datos e instrucciones a seguir a través de tarjetas perforadas de acuerdo con un código. La computadora a su vez proporcionaría las soluciones también en forma de perforaciones en tarjeta. Como consecuencia, esta máquina "programable" ofrecía dos nuevas ventajas: i) por primera vez, una máquina sería capaz de utilizar durante un cálculo los resultados de otro anterior sin necesidad de reconfigurar la máquina, lo cual permitiría llevar a cabo cálculos iterativos, y ii) habría la posibilidad de que la computadora siguiese instrucciones alternas, dependiendo de los resultados de una etapa anterior del cálculo. Babbage describió esta máquina como "la máquina que se muerde la cola".

Con el desarrollo posterior de la electricidad aparecieron las llamadas computadoras electromecánicas, las cuales utilizaban solenoides e interruptores mecánicos operados eléctricamente. La primera de ellas se creó en 1944 y fue la llamada Mark I. Las instrucciones "se cargaban" por medio de cinta de papel con perforaciones, y los datos se proporcionaban en tarjetas de cartón, también perforadas. Esta computadora tenía aproximadamente 15.5 m. de largo por 2.5 de altura, y multiplicaba dos números en aproximadamente 3 segundos. Tres años más tarde, la computadora Mark II. era capaz de llevar a cabo la misma operación en menos de un cuarto de segundo; esto es, 12 veces más rápido.

Mientras estas computadoras analógicas eran construidas, se gestaba un nuevo concepto de computadoras. Éstas eran las llamadas computadoras digitales, acerca de cuya paternidad existen gran cantidad de disputas. Sin embargo, como narraremos a continuación, en una batalla legal en las cortes de los Estados Unidos de América se atribuyó el derecho a llamarse "inventor de la computadora digital" a John V. Atanasoff, un físico estadounidense, hijo de un ingeniero eléctrico y una maestra de álgebra.

Es en esta época cuando Atanasoff tuvo varias ideas muy brillantes que revolucionaron las máquinas calculadoras y que de hecho hicieron posible el inicio de la era moderna de la computación. Estas ideas fueron las siguientes:

El remplazo de los relevadores electromecánicos por bulbos.

La substitución del sistema decimal por el sistema binario.

La utilización de condensadores para construir dispositivos

encargados de guardar información ("memorias").

La primera máquina que llegó a estar en plena operación utilizando los principios ideados por Atanasoff fue la llamada ENIAC y fue

¡precisamente Mauchly! quien la construyó junto con otro

colaborador llamado Presper Eckert. Esta computadora tenía

19000 bulbos, 1 500 relevadores, cientos de miles de capacitores,

resistores e inductores, y aproximadamente 500 000 conexiones

soldadas. Por otro lado, consumía casi 200 kilovatios de potencia y

llevaba a cabo una multiplicación en 2.8 milisegundos (1 000

milisegundos = 1 segundo), esto es, ¡mil veces más rápido que su

predecesora, la computadora Mark II!

La computadora pesaba 7257 kg. aproximadamente, estaba compuesta por 5000 tubos de vacío, y podía ejecutar unos 1000 cálculos por segundo. Era una computadora que procesaba los dígitos en serie. Podía hacer sumas de dos números de diez dígitos cada uno, unas 100000 por segundo.

Así Von Neumann, junto con Babbage se consideran hoy como los padres de la computación.

10

Arquitectura von Neumann y arquitectura Harvard .

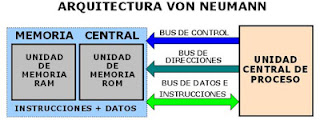

Hay dos arquitecturas distintas relacionadas con el uso y distribución de la memoria: Arquitectura de von Neumman y Arquitectura Harvard.

En un sistema con arquitectura Von Neumann el tamaño de la unidad de datos o instrucciones está fijado

por el ancho del bus que comunica la memoria con la CPU. Así un microprocesador de 8 bits con un bus de 8 bits, tendrá que manejar datos e instrucciones de una o más unidades de 8 bits (bytes) de longitud. Si tiene que acceder a una instrucción o dato de más de un byte de longitud, tendrá que realizar más de un acceso a la memoria.

El tener un único bus hace que el microprocesador sea más lento en su respuesta, ya que no puede buscar

en memoria una nueva instrucción mientras no finalicen las transferencias de datos de la instrucción anterior.

Las principales limitaciones que nos encontramos con la arquitectura Von Neumann son:

por el ancho del bus que comunica la memoria con la CPU. Así un microprocesador de 8 bits con un bus de 8 bits, tendrá que manejar datos e instrucciones de una o más unidades de 8 bits (bytes) de longitud. Si tiene que acceder a una instrucción o dato de más de un byte de longitud, tendrá que realizar más de un acceso a la memoria.

El tener un único bus hace que el microprocesador sea más lento en su respuesta, ya que no puede buscar

en memoria una nueva instrucción mientras no finalicen las transferencias de datos de la instrucción anterior.

Las principales limitaciones que nos encontramos con la arquitectura Von Neumann son:

- La limitación de la longitud de las instrucciones por el bus de datos, que hace que el microprocesador tenga que realizar varios accesos a memoria para buscar instrucciones complejas.

- La limitación de la velocidad de operación a causa del bus único para datos e instrucciones que no deja acceder simultáneamente a unos y otras, lo cual impide superponer ambos tiempos de acceso

Los ordenadores con arquitectura Von Neumann constan de las siguientes partes:

La arquitectura Von Neumann realiza o emula los siguientes pasos secuencialmente:

1) Obtiene la siguiente instrucción desde la memoria en la dirección indicada por el contador de programa y la guarda en el registro de instrucción.

2) Aumenta el contador de programa en la longitud de la instrucción para apuntar a la siguiente.

3) Descodifica la instrucción mediante la unidad de control. Ésta se encarga de coordinar el resto de componentes del ordenador para realizar una función determinada.

4) Se ejecuta la instrucción. Ésta puede cambiar el valor del contador del programa, permitiendo así operaciones repetitivas.

5) Regresa al paso N° 1.

1) Obtiene la siguiente instrucción desde la memoria en la dirección indicada por el contador de programa y la guarda en el registro de instrucción.

2) Aumenta el contador de programa en la longitud de la instrucción para apuntar a la siguiente.

3) Descodifica la instrucción mediante la unidad de control. Ésta se encarga de coordinar el resto de componentes del ordenador para realizar una función determinada.

4) Se ejecuta la instrucción. Ésta puede cambiar el valor del contador del programa, permitiendo así operaciones repetitivas.

5) Regresa al paso N° 1.

Conclusión:

* La mayoría de las computadoras todavía utilizan la arquitectura Von Neumann, propuesta a principios de los años 40 por John Von Neumann.

* La arquitectura Von Neumann describe a la computadora con 4 secciones principales: la unidad lógica y aritmética (ALU), la unidad de control, la memoria, y los dispositivos de entrada y salida (E/S).

* En este sistema, la memoria es una secuencia de celdas de almacenamiento numeradas, donde cada una es un bit, o unidad de información.

La instrucción es la información necesaria para realizar, lo que se desea, con la computadora.

Las celdas contienen datos que se necesitan para llevar a cabo las instrucciones, con la computadora.

* El tamaño de cada celda y el número de celdas varía mucho de computadora a computadora, y las tecnologías empleadas para la memoria han cambiado bastante; van desde los relés electromecánicos, tubos llenos de mercurio en los que se formaban los pulsos acústicos, matrices de imanes permanentes, transistores individuales a circuitos integrados con millones de celdas en un solo chip.

Arquitectura Harvard: Este modelo, que utilizan los Microcontroladores PIC, tiene la unidad central de

proceso (CPU) conectada a dos memorias (una con las instrucciones y otra con los datos) por medio de dos buses diferentes.

* La mayoría de las computadoras todavía utilizan la arquitectura Von Neumann, propuesta a principios de los años 40 por John Von Neumann.

* La arquitectura Von Neumann describe a la computadora con 4 secciones principales: la unidad lógica y aritmética (ALU), la unidad de control, la memoria, y los dispositivos de entrada y salida (E/S).

* En este sistema, la memoria es una secuencia de celdas de almacenamiento numeradas, donde cada una es un bit, o unidad de información.

La instrucción es la información necesaria para realizar, lo que se desea, con la computadora.

Las celdas contienen datos que se necesitan para llevar a cabo las instrucciones, con la computadora.

* El tamaño de cada celda y el número de celdas varía mucho de computadora a computadora, y las tecnologías empleadas para la memoria han cambiado bastante; van desde los relés electromecánicos, tubos llenos de mercurio en los que se formaban los pulsos acústicos, matrices de imanes permanentes, transistores individuales a circuitos integrados con millones de celdas en un solo chip.

Arquitectura Harvard: Este modelo, que utilizan los Microcontroladores PIC, tiene la unidad central de

proceso (CPU) conectada a dos memorias (una con las instrucciones y otra con los datos) por medio de dos buses diferentes.

Una de las memorias contiene solamente las instrucciones del programa (Memoria de Programa), y la otra

sólo almacena datos (Memoria de Datos).

Ambos buses son totalmente independientes lo que permite que la CPU pueda acceder de forma

independiente y simultánea a la memoria de datos y a la de instrucciones. Como los buses son independientes estos pueden tener distintos contenidos en la misma dirección y también distinta longitud.

Tambien la longitud de los datos y las instrucciones puede ser distinta, lo que optimiza el uso de la memoria en general.

Para un procesador de Set de Instrucciones Reducido, o RISC (Reduced Instrucción Set Computer), el set de instrucciones y el bus de memoria de programa pueden diseñarse de tal manera que todas las instrucciones tengan una sola posición de memoria de programa de longitud.

Además, al ser los buses independientes, la CPU puede acceder a los datos para completar la ejecución de

una instrucción, y al mismo tiempo leer la siguiente instrucción a ejecutar.

Ventajas de esta arquitectura:

* El tamaño de las instrucciones no esta relacionado con el de los datos, y por lo tanto puede ser

optimizado para que cualquier instrucción ocupe una sola posición de memoria de programa,

logrando así mayor velocidad y menor longitud de programa.

* El tiempo de acceso a las instrucciones puede superponerse con el de los datos, logrando una

mayor velocidad en cada operación.

sólo almacena datos (Memoria de Datos).

Ambos buses son totalmente independientes lo que permite que la CPU pueda acceder de forma

independiente y simultánea a la memoria de datos y a la de instrucciones. Como los buses son independientes estos pueden tener distintos contenidos en la misma dirección y también distinta longitud.

Tambien la longitud de los datos y las instrucciones puede ser distinta, lo que optimiza el uso de la memoria en general.

Para un procesador de Set de Instrucciones Reducido, o RISC (Reduced Instrucción Set Computer), el set de instrucciones y el bus de memoria de programa pueden diseñarse de tal manera que todas las instrucciones tengan una sola posición de memoria de programa de longitud.

Además, al ser los buses independientes, la CPU puede acceder a los datos para completar la ejecución de

una instrucción, y al mismo tiempo leer la siguiente instrucción a ejecutar.

Ventajas de esta arquitectura:

* El tamaño de las instrucciones no esta relacionado con el de los datos, y por lo tanto puede ser

optimizado para que cualquier instrucción ocupe una sola posición de memoria de programa,

logrando así mayor velocidad y menor longitud de programa.

* El tiempo de acceso a las instrucciones puede superponerse con el de los datos, logrando una

mayor velocidad en cada operación.

GENERACIONES

La historia reciente de la computación se ha dividido en las llamadas generaciones de computadoras, cada una de las cuales está caracterizada por un desarrollo o una innovación importante. A continuación haremos una breve reseña de estas etapas.

Todo este desarrollo de las computadoras suele divisarse por generaciones.

Primera Generación (1951-1958)

En esta generación había una gran desconocimiento de las capacidades de las computadoras, puesto que se realizó un estudio en esta época que determinó que con veinte computadoras se saturaría el mercado de los Estados Unidos en el campo de procesamiento de datos. Esta generación abarco la década de los cincuenta. Y se conoce como la primera generación. Estas máquinas tenían las siguientes características:

|

En esta generación las máquinas son grandes y costosas (de un costo aproximado de 10,000 dólares).

La computadora más exitosa de la primera generación fue la IBM 650, de la cual se produjeron varios cientos. Esta computadora que usaba un esquema de memoria secundaria llamado tambor magnético, que es el antecesor de los discos actuales.

Segunda Generación (1958-1964)

En esta generación las computadoras se reducen de tamaño y son de menor costo. Aparecen muchas compañías y las computadoras eran bastante avanzadas para su época como la serie 5000 de Burroughs y la ATLAS de la Universidad de Manchester. Algunas computadoras se programaban con cinta perforadas y otras por medio de cableado en un tablero.

|

Características de está generación:

Usaban transistores para procesar información.

Los transistores eran más rápidos, pequeños y más confiables que los tubos al vacío. 200 transistores podían acomodarse en la misma cantidad de espacio que un tubo al vacío.

Usaban pequeños anillos magnéticos para almacenar información e instrucciones. cantidad de calor y eran sumamente lentas.

Se mejoraron los programas de computadoras que fueron desarrollados durante la primera generación.

Se desarrollaron nuevos lenguajes de programación como COBOL y FORTRAN, los cuales eran comercialmente accsesibles.

Se usaban en aplicaciones de sistemas de reservaciones de líneas aéreas, control del tráfico aéreo y simulaciones de propósito general.

La marina de los Estados Unidos desarrolla el primer simulador de vuelo, "Whirlwind I".

Surgieron las minicomputadoras y los terminales a distancia.

Se comenzó a disminuir el tamaño de las computadoras.

Se desarrollaron los "chips" para almacenar y procesar la información. Un "chip" es una pieza de silicio que contiene los componentes electrónicos en miniatura llamados semiconductores.

Los circuitos integrados recuerdan los datos, ya que almacenan la información como cargas eléctricas.

Surge la multiprogramación.

Las computadoras pueden llevar a cabo ambas tareas de procesamiento o análisis matemáticos.

Emerge la industria del "software".

Se desarrollan las minicomputadoras IBM 360 y DEC PDP-1.

Otra vez las computadoras se tornan más pequeñas, más ligeras y más eficientes.

Se colocan más circuitos dentro de un "chip".

"LSI - Large Scale Integration circuit".

"VLSI - Very Large Scale Integration circuit".

Cada "chip" puede hacer diferentes tareas.

Un "chip" sencillo actualmente contiene la unidad de control y la unidad de aritmética/lógica. El tercer componente, la memoria primaria, es operado por otros "chips".

Se reemplaza la memoria de anillos magnéticos por la memoria de "chips" de silicio.

Se desarrollan las microcomputadoras, o sea, computadoras personales o PC.

Se desarrollan las supercomputadoras.

Tercera Generación (1964-1971)

La tercera generación de computadoras emergió con el desarrollo de circuitos integrados (pastillas de silicio) en las que se colocan miles de componentes electrónicos en una integración en miniatura. Las computadoras nuevamente se hicieron más pequeñas, más rápidas, desprendían menos calor y eran energéticamente más eficientes. El ordenador IBM-360 dominó las ventas de la tercera generación de ordenadores desde su presentación en 1965. El PDP-8 de la Digital Equipment Corporation fue el primer miniordenador.

|

Características de está generación:

Se desarrollaron circuitos integrados para procesar información.Se desarrollaron los "chips" para almacenar y procesar la información. Un "chip" es una pieza de silicio que contiene los componentes electrónicos en miniatura llamados semiconductores.

Los circuitos integrados recuerdan los datos, ya que almacenan la información como cargas eléctricas.

Surge la multiprogramación.

Las computadoras pueden llevar a cabo ambas tareas de procesamiento o análisis matemáticos.

Emerge la industria del "software".

Se desarrollan las minicomputadoras IBM 360 y DEC PDP-1.

Otra vez las computadoras se tornan más pequeñas, más ligeras y más eficientes.

Cuarta Generación (1971-1988)

Aparecen los microprocesadores que es un gran adelanto de la microelectrónica, son circuitos integrados de alta densidad y con una velocidad impresionante. Las microcomputadoras con base en estos circuitos son extremadamente pequeñas y baratas, por lo que su uso se extiende al mercado industrial. Aquí nacen las computadoras personales que han adquirido proporciones enormes y que han influido en la sociedad en general sobre la llamada "revolución informática".

|

Características de está generación:

Se desarrolló el microprocesador.Se colocan más circuitos dentro de un "chip".

"LSI - Large Scale Integration circuit".

"VLSI - Very Large Scale Integration circuit".

Cada "chip" puede hacer diferentes tareas.

Un "chip" sencillo actualmente contiene la unidad de control y la unidad de aritmética/lógica. El tercer componente, la memoria primaria, es operado por otros "chips".

Se reemplaza la memoria de anillos magnéticos por la memoria de "chips" de silicio.

Se desarrollan las microcomputadoras, o sea, computadoras personales o PC.

Se desarrollan las supercomputadoras.

Quinta Generación (1983 al presente)

En vista de la acelerada marcha de la microelectrónica, la sociedad industrial se ha dado a la tarea de poner también a esa altura el desarrollo del software y los sistemas con que se manejan las computadoras. Surge la competencia internacional por el dominio del mercado de la computación, en la que se perfilan dos líderes que, sin embargo, no han podido alcanzar el nivel que se desea: la capacidad de comunicarse con la computadora en un lenguaje más cotidiano y no a través de códigos o lenguajes de control especializados.

Japón lanzó en 1983 el llamado "programa de la quinta generación de computadoras", con los objetivos explícitos de producir máquinas con innovaciones reales en los criterios mencionados. Y en los Estados Unidos ya está en actividad un programa en desarrollo que persigue objetivos semejantes, que pueden resumirse de la siguiente manera:

Inteligencia artíficial:

La inteligencia artificial es el campo de estudio que trata de aplicar los procesos del pensamiento humano usados en la solución de problemas a la computadora.

Robótica:

La robótica es el arte y ciencia de la creación y empleo de robots. Un robot es un sistema de computación híbrido independiente que realiza actividades físicas y de cálculo. Están siendo diseñados con inteligencia artificial, para que puedan responder de manera más efectiva a situaciones no estructuradas.

Sistemas expertos:

Un sistema experto es una aplicación de inteligencia artificial que usa una base de conocimiento de la experiencia humana para ayudar a la resolución de problemas.

Redes de comunicaciones:

Los canales de comunicaciones que interconectan terminales y computadoras se conocen como redes de comunicaciones; todo el "hardware" que soporta las interconexiones y todo el "software" que administra la transmisión.

No hay comentarios:

Publicar un comentario